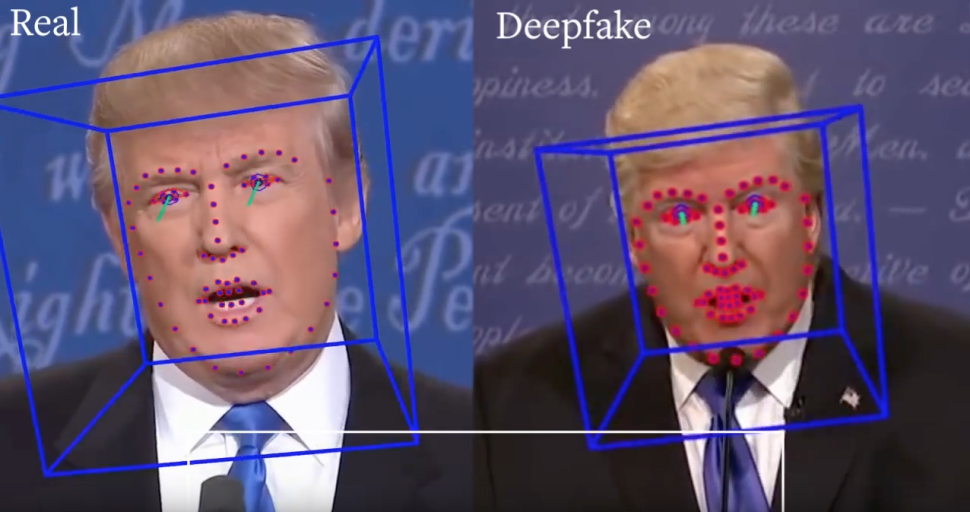

Los sistemas diseñados para detectar deepfakes (videos que manipulan imágenes de la vida real a través de inteligencia artificial) pueden ser engañados, como sugiere este estudio.

Los investigadores han demostrado que los detectores se pueden derrotar insertando ejemplos de contradictorios en cada cuadro de video. Los ejemplos contradictorios son entradas ligeramente manipuladas que hacen que los sistemas de inteligencia artificial, como los modelos de aprendizaje automático, cometan un error.

Atacando los puntos ciegos

En los deepfakes la cara de un sujeto se modifica para crear imágenes realistas y convincentes de eventos que nunca sucedieron. Como resultado, los detectores de deepfake típicos se enfocan en el rostro en los videos: primero lo rastrean y luego pasan los datos del rostro recortado a una red neuronal que determina si es real o falso.

Por ejemplo, el parpadeo de los ojos no se reproduce bien en los deepfakes, por lo que los detectores se enfocan en los movimientos oculares como una forma de detectar que el vídeo es falso.

Sin embargo, si los creadores de un vídeo falso tienen algún conocimiento del sistema de detección, pueden diseñar entradas para apuntar a los puntos ciegos del detector y evitarlo.

Los investigadores crearon un ejemplo de confrontación para cada rostro en un cuadro de video. Pero si bien las operaciones estándar, como comprimir y cambiar el tamaño de un video, generalmente eliminan los ejemplos contradictorios de una imagen, estos ejemplos están diseñados para resistir estos procesos. El algoritmo de ataque hace esto estimando sobre un conjunto de transformaciones de entrada cómo el modelo clasifica las imágenes como reales o falsas. A continuación, se inserta la versión modificada de la cara en todos los fotogramas de vídeo. Luego, el proceso se repite para todos los fotogramas del video para crear un video deepfake.

Para mejorar los detectores, los investigadores recomiendan un enfoque similar a lo que se conoce como Adversarial Machine Learning o entrenamiento adversario: durante el entrenamiento, un adversario adaptativo continúa generando nuevos deepfakes que pueden eludir el detector actual de última generación; y el detector sigue mejorando para detectar los nuevos deepfakes.

Fuente: Xataka Ciencia

Por: Maria Laura Espinoza

Twitter: @i_am_LauEz14